Hogyan működnek a webes keresőrobotok? Teljes technikai útmutató

Ismerje meg, hogyan működnek a webes keresőrobotok a kezdő URL-ektől az indexelésig. Értse meg a technikai folyamatokat, a keresőrobotok típusait, a robots.txt ...

Tudja meg, mi az a Google Spider (Googlebot), hogyan térképezi fel és indexeli a weboldalakat, és miért nélkülözhetetlen a SEO szempontjából. Ismerje meg, hogyan optimalizálhatja webhelyét a jobb feltérképezés érdekében.

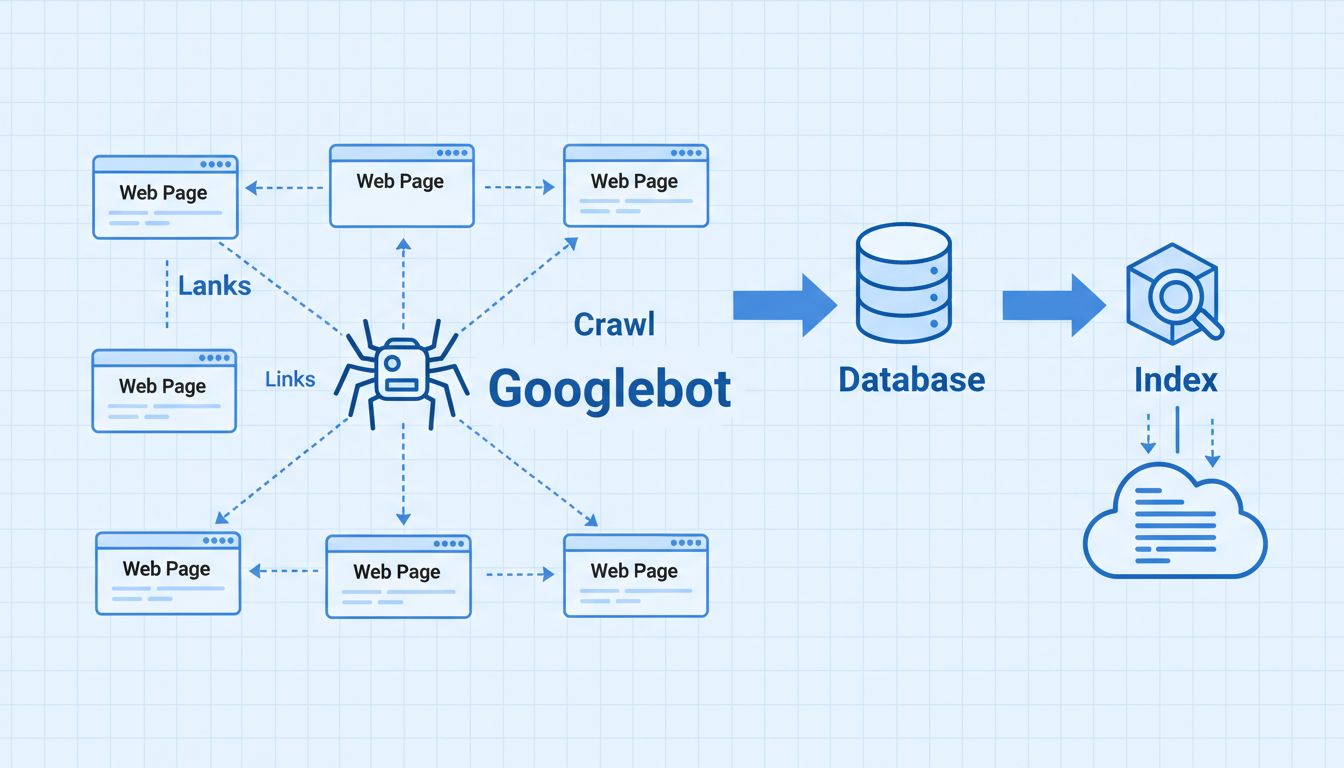

A Google Spider, hivatalos nevén Googlebot, egy automatizált program, amely weboldalakat térképez fel, hogy felfedezze, indexelje és eltárolja a tartalmat a Google adatbázisában. Linkeket követve találja meg az új vagy frissített oldalakat, amelyeket feldolgoz, majd hozzáad a Google keresési indexéhez, lehetővé téve, hogy a kereső releváns találatokat nyújtson a felhasználóknak.

A Google Spider, hivatalos nevén Googlebot, egy automatizált szoftverprogram, amely rendszerezetten feltérképezi az internetet, hogy webes tartalmat fedezzen fel, elemezzen és indexeljen. Ez a Google elsődleges eszköze a weboldalak felfedezésére, az információk összegyűjtésére és hatalmas keresési indexének felépítésére. Googlebot nélkül a Google nem tudna új oldalakat felfedezni, frissítéseket észlelni a meglévő tartalmakon, vagy releváns keresési találatokat szolgáltatni világszerte több milliárd felhasználónak. A spider folyamatosan működik, naponta weboldalak millióit látogatja meg, hogy a Google indexe mindig aktuális és átfogó maradjon.

A Googlebot lényegében egy kifinomult webrobot, amely összetett algoritmikus folyamat szerint dönti el, mely oldalakat látogassa meg, milyen gyakran térképezze fel őket, illetve hány oldalt töltsön le adott domainről. A robot beolvassa az oldal HTML-kódját, szöveges tartalmát és metaadatait, majd ezt az információt eltárolja a Google központi adatbázisában. Ez az indexelési folyamat alapja a keresőmotorok működésének, és közvetlenül befolyásolja weboldala láthatóságát a keresési találatok között.

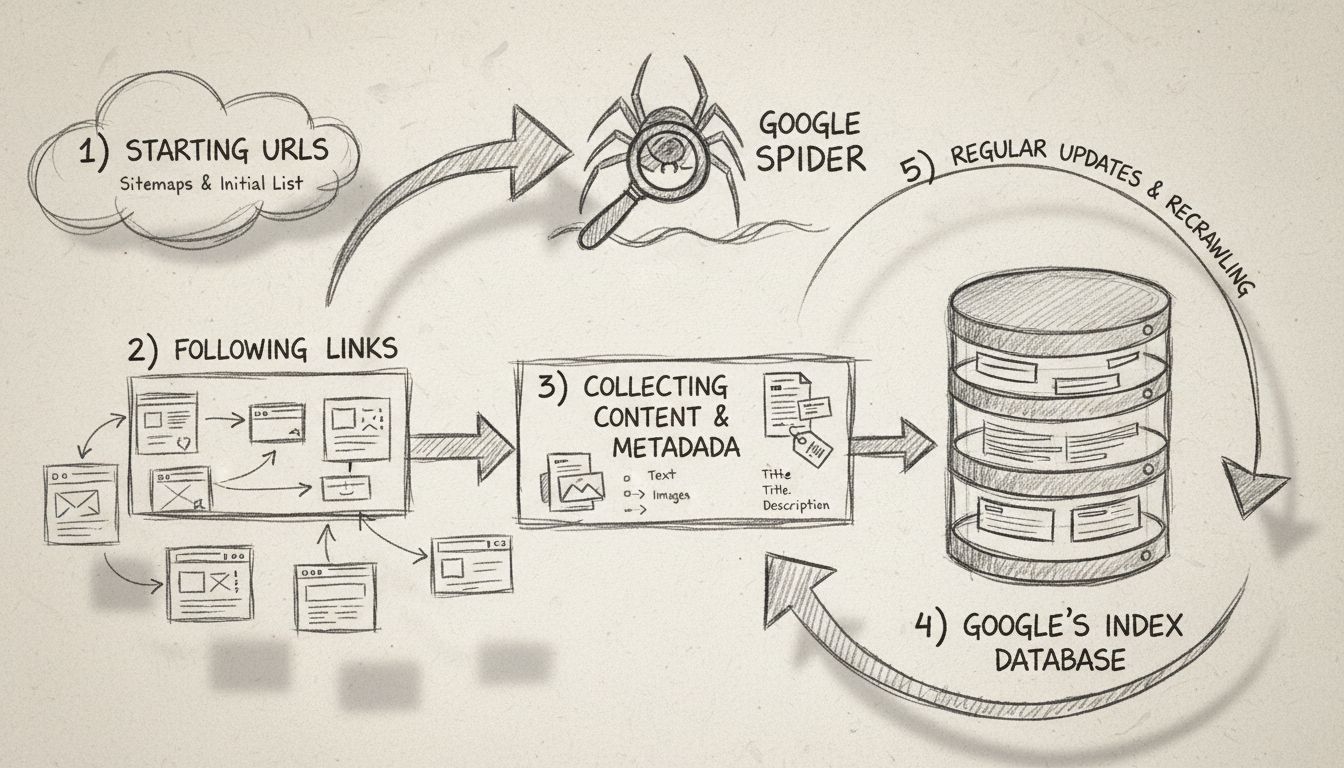

A Google Spider egy jól meghatározott feltérképezési folyamaton keresztül működik, amely egy úgynevezett seed listával (alap URL lista) kezdődik. Ez a lista korábbi feltérképezési folyamatokból származik, és folyamatosan bővül a webmesterek által a Google Search Console-on keresztül beküldött webhelytérképek adataival. Amikor a Googlebot meglátogat egy weboldalt, nem csak a tartalmat olvassa el – átfogó elemzést végez az oldal szerkezetéről, követi a belső és külső linkeket, valamint azonosítja az esetleges változásokat vagy új tartalmakat az előző látogatás óta.

A feltérképezési folyamat fő lépései a következők: Először a Googlebot egy korábbi feltérképezésből és webhelytérképekből származó URL-listával indul. Másodszor, linkeket (SRC és HREF attribútumokat) követve navigál a webhelyeken, hogy új tartalmakat fedezzen fel. Harmadszor, letölti és elemzi az egyes oldalak tartalmát, beleértve a szöveget, a HTML-struktúrát, a metaadatokat és minden egyéb releváns információt. Negyedszer, az összegyűjtött adatokat a Google szervereire továbbítja feldolgozásra és keresési indexbe történő tárolásra. Végül a Googlebot rendszeres időközönként visszatér a webhelyekre, hogy ellenőrizze az új tartalmakat, frissítéseket vagy változásokat a meglévő oldalakon.

A Google több speciális feltérképezőt (crawler) is működtet, amelyek mindegyike egyedi felhasználói ügynök (user-agent) karakterlánccal azonosítható, és speciális célokra használatos. Ezek ismerete segít a webhelytulajdonosoknak abban, hogy megfelelően optimalizálják oldalaikat. A fő Googlebot-variánsok közé tartozik az asztali feltérképező, a mobil feltérképező, a videófeltérképező, a képkereső feltérképező és a hírfeltérképező – mindegyik más-más szerepet tölt be a Google indexelési ökoszisztémájában.

| Googlebot típus | User-Agent karakterlánc | Cél |

|---|---|---|

| Googlebot (asztali) | Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html) | Az oldalak asztali verzióját térképezi fel az általános keresési indexhez |

| Googlebot (mobil) | Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/W.X.Y.Z Mobile Safari/537.36 (compatible; Googlebot/2.1; +http://www.google.com/bot.html) | Mobilra optimalizált weboldalakat térképez fel |

| Googlebot-Video | Googlebot-Video/1.0 | Beágyazott videótartalmak indexelése |

| Googlebot-Image | Googlebot-Image/1.0 | Képek feltérképezése és indexelése a Google Képek keresőhöz |

| Googlebot-News | Googlebot-News | Hírtartalmak feltérképezése a Google Hírek aggregálásához |

Ezen elsődleges feltérképezőkön túl a Google további speciális botokat is működtet más célokra. Az AdSense Bot például hirdetések minőségét és megfelelőségét ellenőrzi, míg a Mobile Apps Android feltérképező az Android-alkalmazások tartalmát indexeli. Mindegyik botnak saját user-agent azonosítója van, így a webhelyadminisztrátorok a szervernaplókban nyomon követhetik, hogy melyik feltérképező látogatta meg oldalukat. Ez azért fontos, mert az eltérő feltérképezők különböző gyakorisággal és prioritással térképezhetik fel az oldalt, ami befolyásolhatja a webhely látogatásának gyakoriságát.

A Google Spider kiemelten fontos a keresőoptimalizálásban, hiszen tőle függ, hogy weboldala tartalma felfedezésre, indexelésre és rangsorolásra kerül-e a keresési találatokban. Ha a Googlebot nem tudja hatékonyan feltérképezni webhelyét, az oldalai nem kerülnek be a Google indexébe, így láthatatlanok maradnak a potenciális látogatók számára, akik az Ön termékeit vagy szolgáltatásait keresik. Ezért a technikai SEO – azaz annak biztosítása, hogy webhelye feltérképező-barát legyen – minden sikeres SEO stratégia egyik legfontosabb alapja.

Amikor a Googlebot feltérképezi webhelyét, hatalmas indexet készít minden megtalált szóról és azok helyéről az egyes oldalakon, valamint HTML-információkról, például címkékről, meta leírásokról és címsorokról. Ezeket az adatokat a Google adatbázisában tárolja, és a keresőalgoritmusok használják fel az oldalak rangsorolásához, valamint annak eldöntéséhez, hogy tartalma mennyire értékes egy adott keresési lekérdezésnél. Minél hatékonyabban tudja a Googlebot feltérképezni webhelyét, annál gyakrabban tér vissza, és annál gyorsabban kerülhetnek be az új tartalmak a keresési találatok közé.

Ahhoz, hogy a Googlebot hatékonyan és eredményesen tudja feltérképezni weboldalát, több technikai legjobb gyakorlatot is alkalmaznia kell. Először is, tartson fenn átlátható és logikus webhelystruktúrát, megfelelő navigációval, hogy a feltérképező könnyen megtalálja az összes fontos oldalt. A belső linkelés legyen stratégiai és releváns, használjon leíró horgonyszöveget, amely a felhasználók és a feltérképezők számára is segít megérteni a hivatkozott oldal tartalmát. Weboldalának gyorsan kell betöltődnie, mivel az oldalbetöltési sebesség befolyásolja a feltérképezés hatékonyságát és azt, hogy a Googlebot mennyi oldalt tud bejárni a kiosztott feltérképezési kereten belül.

Készítsen és küldjön be XML webhelytérképet a Google Search Console-ba, amely teljes listát ad a Googlebotnak az összes indexelni kívánt oldalról. Ez különösen fontos nagy weboldalak vagy olyan oldalak esetén, amelyeket belső linkeléssel nehezebb elérhetővé tenni. Ezenkívül győződjön meg róla, hogy robots.txt fájlja megfelelően van beállítva: engedélyezze a Googlebot számára a fontos oldalak elérését, miközben blokkolja az érzékeny vagy duplikált tartalmakat. Ügyeljen azonban arra, hogy véletlenül ne blokkolja a fontos oldalakat, mert így azok teljesen kimaradnak az indexelésből.

A Google Search Console elengedhetetlen eszköz annak ellenőrzésére, hogyan lép kapcsolatba a Googlebot a weboldalával, és azonosíthatja azokat a feltérképezési problémákat, amelyek hátráltatják a megfelelő indexelést. A Feltérképezési statisztikák szekció részletes információkkal szolgál arról, hogy hány oldalt térképezett fel a Googlebot, mennyi időt töltött a webhelyen, illetve hány hibát észlelt. Megtekintheti a szerver átlagos válaszidejét is, amely közvetlenül befolyásolja, mennyire hatékonyan tudja a Googlebot feltérképezni az oldalait – lassabb szerverek esetén kevesebb oldal kerül bejárásra ugyanannyi idő alatt.

A Lefedettség jelentés a Google Search Console-ban megmutatja, mely oldalak lettek sikeresen indexelve, melyeknél hibák akadályozzák az indexelést, illetve mely oldalak vannak kizárva az indexből. Ez az információ felbecsülhetetlen értékű, ha technikai problémákat – például hibás linkeket, szerverhibákat vagy robots.txt által blokkolt oldalakat – kell azonosítani, amelyekről talán nem is tudott. Az URL-ellenőrző eszközzel azt is tesztelheti, hogyan látja egy adott oldalt a Googlebot, beleértve, hogy képes-e megjeleníteni a JavaScript-tartalmat, és hozzáfér-e minden erőforráshoz, ami az oldal helyes megjelenítéséhez szükséges.

Minden weboldalnak van egy úgynevezett „feltérképezési kerete” (crawl budget) – az az oldalszám, amelyet a Googlebot egy adott időszakban bejár a webhelyen. A legtöbb weboldal esetében a feltérképezési keret nem jelent korlátot, de nagyon nagy, több ezer vagy milliónyi oldalt tartalmazó site-oknál fontos lehet az optimalizálása. A Google a feltérképezési keretet két tényező alapján határozza meg: a feltérképezési kapacitás (mennyit bír el a szerver), illetve a feltérképezési igény (mennyire tartja fontosnak a Google az oldalt). Ha növeli oldala sebességét és javítja a feltérképezési hibákat, nő a kapacitás, míg a gyakran frissített, értékes tartalmak növelik az igényt.

A feltérképezési keret optimalizálásához szüntesse meg a duplikált tartalmakat, amelyek feleslegesen kötik le a feltérképező erőforrásait, javítsa a hibás linkeket és átirányítási láncokat, valamint távolítsa el azokat az oldalakat, amelyek nem képviselnek értéket a felhasználók számára. Ne blokkoljon fontos oldalakat robots.txt vagy noindex címkékkel, és alakítsa ki úgy a webhelystruktúrát, hogy a Googlebot néhány kattintással eljusson minden lényeges oldalhoz a kezdőlapról. Rendszeresen frissítse XML webhelytérképét, és távolítsa el a régi, elavult oldalakat, hogy a Googlebot a legfontosabb tartalmakra összpontosíthassa feltérképezési erőforrásait.

A webhelytulajdonosok gyakran találkoznak olyan problémákkal, amelyek megakadályozzák, hogy a Googlebot hatékonyan térképezze fel oldalaikat. Szerverhibák (5xx státuszkódok) azt jelzik, hogy a szerver nem tudja kiszolgálni a kéréseket, így az oldalak nem kerülnek indexelésre. Az átirányítási láncok – amikor egy oldal egy másikra, az pedig egy harmadikra irányít át – feltérképezési keretet pazarolnak, és lassítják az indexelési folyamatot. Blokkolt erőforrások, például CSS- vagy JavaScript-fájlok, amelyeket robots.txt tilt, megakadályozhatják, hogy a Googlebot helyesen jelenítse meg és értelmezze az oldalakat.

A „puha” 404 hibák akkor fordulnak elő, amikor egy oldal 200-as státuszkódot (sikeres betöltés) ad vissza, de valójában szinte semmilyen tartalmat nem tartalmaz, így a Googlebot nem tudja eldönteni, hogy indexelni kell-e. Fontos oldalakra véletlenül alkalmazott noindex címkék miatt ezek nem jelennek meg a keresési találatokban. Lassú oldalbetöltés miatt kevesebb oldalt tud feltérképezni a Googlebot a rendelkezésre álló idő alatt. Ezek megoldásához rendszeresen auditálja webhelyét a Google Search Console-lal, figyelje a szervernaplókat feltérképezési hibák után kutatva, és használjon eszközöket (pl. Screaming Frog) a technikai hibák azonosítására még azelőtt, hogy azok befolyásolnák keresési láthatóságát.

2025-ben a Google Spider továbbra is ugyanolyan fontos, mint valaha, de szerepe folyamatosan fejlődik az új technológiák és tartalomtípusok megjelenésével. A Googlebot ma már képes JavaScript-feldolgozásra, vagyis dinamikusan, JavaScript-keretrendszerek által generált tartalmak feltérképezésére és indexelésére is. Emellett kezeli a strukturált adatok (Schema.org) feldolgozását, hogy jobban megértse az oldalak tartalmát, és gazdag találati kivonatokat jeleníthessen meg a keresési eredményekben. A mobil-első indexelés miatt a Googlebot elsődlegesen webhelye mobil verzióját térképezi fel és indexeli, így a mobil optimalizálás elengedhetetlen a SEO sikeréhez.

A spider kulcsszerepet játszik abban is, hogy a Google felismerje és kiszűrje a spamet, azonosítsa a feltört tartalmakat, valamint biztosítsa, hogy a keresési találatok relevánsak és megbízhatóak maradjanak. Ahogy a keresőmotorok egyre fejlettebbé válnak a mesterséges intelligencia és a gépi tanulás révén, a Googlebot feltérképezési és indexelési képességei is egyre kifinomultabbak lesznek, lehetővé téve, hogy a Google jobban értelmezze a felhasználói szándékot, és pontosabb keresési találatokat szolgáltasson. A Googlebot működésének ismerete és weboldalának ennek megfelelő optimalizálása továbbra is a SEO stratégia egyik legfontosabb alappillére.

Ahogyan a Google Spider feltérképezi és indexeli a tartalmát, úgy segít a PostAffiliatePro nyomon követni és optimalizálni partnerprogramjának teljesítményét. Kövesse nyomon minden kattintást, konverziót és jutalékot iparágvezető affiliate menedzsment platformunkkal.

Ismerje meg, hogyan működnek a webes keresőrobotok a kezdő URL-ektől az indexelésig. Értse meg a technikai folyamatokat, a keresőrobotok típusait, a robots.txt ...

A robotok (crawlers) adatokat és információkat gyűjtenek az internetről weboldalak meglátogatásával és az oldalak tartalmának olvasásával. Tudjon meg többet ról...

A keresőmotor egy olyan szoftver, amelyet azért hoztak létre, hogy megkönnyítse a felhasználók számára az internetes keresést. Több millió oldalt vizsgál át, és...

Sütik Hozzájárulás

A sütiket használjuk, hogy javítsuk a böngészési élményt és elemezzük a forgalmunkat. See our privacy policy.