Hogyan működnek a webes keresőrobotok? Teljes technikai útmutató

Ismerje meg, hogyan működnek a webes keresőrobotok a kezdő URL-ektől az indexelésig. Értse meg a technikai folyamatokat, a keresőrobotok típusait, a robots.txt ...

A robotok, más néven spiderek vagy botok, rendszeresen böngészik és indexelik az internetet, lehetővé téve a keresőmotorok számára a weboldalak megértését és rangsorolását releváns keresésekhez.

A robotok, más néven spiderek vagy botok, fejlett automatizált szoftverprogramok, amelyek célja az internet hatalmas területének rendszerezett böngészése és indexelése. Elsődleges feladatuk, hogy segítsék a keresőmotorokat a weboldalak megértésében, kategorizálásában és rangsorolásában relevancia és tartalom alapján. Ez a folyamat elengedhetetlen ahhoz, hogy a keresőmotorok pontos találatokat nyújtsanak a felhasználóknak. Azáltal, hogy folyamatosan pásztázzák a weboldalakat, a robotok átfogó indexet állítanak össze, amelyet például a Google használ a pontos és releváns keresési eredmények szállításához.

A webrobotok lényegében a keresőmotorok szemei és fülei, lehetővé téve számukra, hogy “lássák”, mi található egy-egy weboldalon, megértsék annak tartalmát, és eldöntsék, hová illeszkedik az indexben. Ismert URL-listával indulnak, majd módszeresen végighaladnak minden oldalon, elemzik a tartalmat, azonosítják a linkeket, és hozzáadják azokat a soron következő feltérképezési sorhoz. Ez az iteratív folyamat lehetővé teszi, hogy a robotok feltérképezzék a teljes web szerkezetét, akárcsak egy digitális könyvtáros, aki könyveket kategorizál.

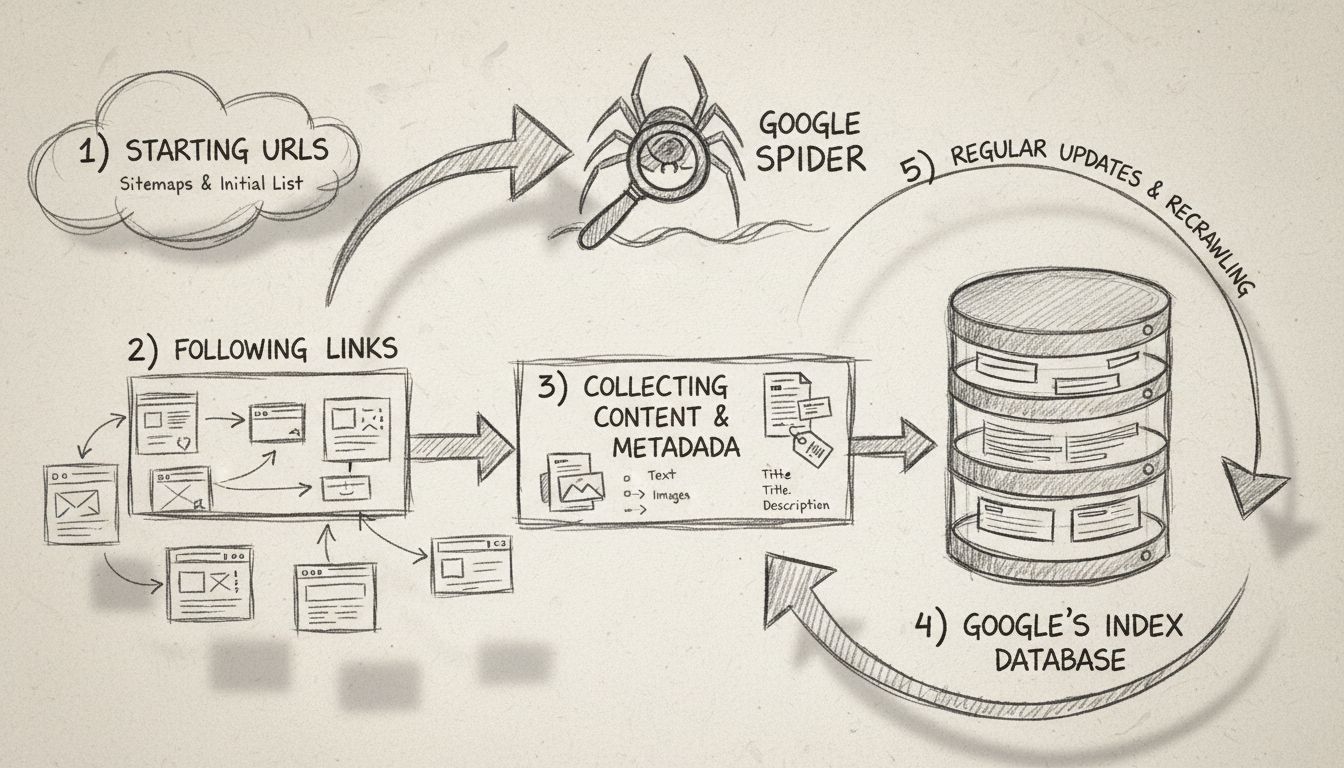

A robotok egy kezdeti URL-listával (seed list) indulnak, amelyeket meglátogatnak és átvizsgálnak. Az oldalak feldolgozása közben azonosítják a további linkeket, amelyeket későbbi feltérképezés céljából sorba állítanak. Ez a folyamat lehetővé teszi, hogy feltérképezzék a web szerkezetét, linkeket követve egyik oldalról a másikra, hasonlóan egy digitális könyvtároshoz. Minden oldal tartalmát – beleértve a szöveget, képeket és meta tageket – elemzik és elmentik egy hatalmas indexbe. Ez az index szolgál alapul a keresőmotorok számára, hogy felhasználói lekérdezésekre releváns információkat tudjanak előhívni.

A webrobotok minden meglátogatott weboldalon megvizsgálják a robots.txt fájlt. Ez a fájl szabályokat tartalmaz arról, mely oldalakat lehet feltérképezni és melyeket kell kihagyni. A szabályok ellenőrzése után a robotok a meghatározott irányelvek, például az oldalra mutató linkek száma vagy az oldal “tekintélye” alapján navigálnak az oldalon. Ezek az irányelvek segítenek prioritást adni annak, hogy mely oldalakat térképezik fel először, így a fontosabb vagy relevánsabb tartalmak gyorsabban kerülnek indexelésre.

A feltérképezés során a botok elmentik minden oldal tartalmát és metaadatait. Ezek az információk elengedhetetlenek a keresőmotorok számára annak eldöntéséhez, hogy egy oldal mennyire releváns egy felhasználói kereséshez. Az összegyűjtött adatok ezután indexelődnek, lehetővé téve, hogy a keresőmotor gyorsan előhívja és rangsorolja az oldalakat egy keresés során.

Az affiliate marketingesek , számára elengedhetetlen a robotok működésének ismerete weboldalaik optimalizálásához és keresőmotoros helyezésük javításához. A hatékony SEO lényege, hogy a webes tartalom olyan szerkezetű legyen, amelyet ezek a botok könnyen elérnek és értelmeznek. Fontos SEO gyakorlatok:

Az affiliate marketing világában a robotok szerepe árnyaltabb. Néhány fő szempont:

Az affiliate marketingesek használhatnak olyan eszközöket, mint a Google Search Console, hogy információkat szerezzenek arról, hogyan viselkednek a robotok a webhelyükön. Ezek az eszközök adatokat szolgáltatnak feltérképezési hibákról, sitemap beadásokról és egyéb mutatókról, lehetővé téve a weboldal feltérképezhetőségének és indexelésének javítását. A feltérképezési aktivitás monitorozása segít azonosítani azokat a problémákat, amelyek akadályozhatják az indexelést, így időben javíthatók.

Az indexelt tartalom nélkülözhetetlen a keresőmotoros láthatósághoz. Ha egy weboldal nincs indexelve, nem jelenik meg a keresési eredményekben, függetlenül attól, mennyire releváns a kereséshez. Az affiliate partnerek számára különösen fontos, hogy tartalmaik indexelésre kerüljenek, hiszen ez alapvetően befolyásolja az organikus forgalmat és a konverziós arányokat. A megfelelő indexelés biztosítja, hogy a tartalom megtalálható és rangsorolható legyen.

A technikai SEO a weboldal infrastruktúrájának optimalizálását jelenti a hatékony feltérképezés és indexelés érdekében. Ez magában foglalja:

Strukturált adatok: Strukturált adatok bevezetése segíti a robotokat a tartalom kontextusának megértésében, növelve az esélyt a kiemelt keresési találatokban való megjelenésre. A strukturált adatok kiegészítő információt nyújtanak, amely javíthatja a keresési láthatóságot.

Webhely sebessége és teljesítménye: A gyorsan betöltődő webhelyeket előnyben részesítik a robotok, és hozzájárulnak a pozitív felhasználói élményhez is. A fokozott webhelysebesség jobb rangsorolást és nagyobb forgalmat eredményezhet.

Hibamentes oldalak: A feltérképezési hibák azonosítása és javítása biztosítja, hogy minden fontos oldal elérhető és indexelhető legyen. A rendszeres auditok segítenek a webhely egészségének megőrzésében és a SEO teljesítmény javításában.

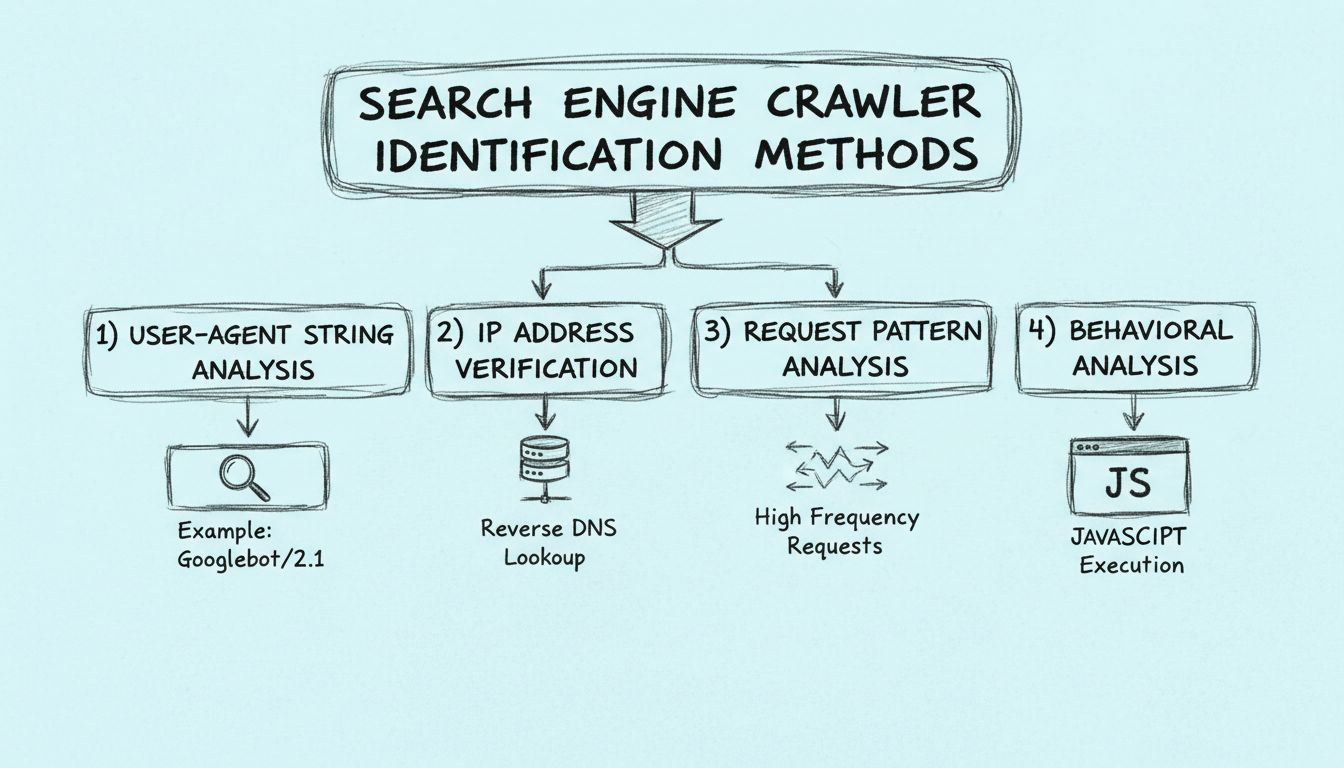

A keresőmotor robotok többféleképpen is azonosíthatók, például a robot user-agent stringjének vizsgálatával, a robot IP-címének elemzésével, illetve a kérésfejlécekben található mintázatok keresésével.

A webrobotok úgy működnek, hogy kéréseket küldenek weboldalakra, majd követik az ezeken az oldalakon található linkeket más oldalakra. Nyilvántartják a meglátogatott oldalakat és a talált linkeket, hogy indexelhessék a webet és kereshetővé tehessék azt.

A webrobotokat azért hívják spidereknek, mert úgy 'másznak végig' a weben, hogy linkeket követnek egyik oldalról a másikra.

Tudja meg, hogyan javíthatja weboldala láthatóságát és keresőmotoros helyezését a robotok megértésével és optimalizálásával.

Ismerje meg, hogyan működnek a webes keresőrobotok a kezdő URL-ektől az indexelésig. Értse meg a technikai folyamatokat, a keresőrobotok típusait, a robots.txt ...

Ismerje meg, hogyan azonosíthatja a keresőmotorok robotjait user-agent stringek, IP-címek, kérések mintázata és viselkedéselemzés segítségével. Alapvető útmutat...

Tudja meg, mi az a Google Spider (Googlebot), hogyan térképezi fel és indexeli a weboldalakat, és miért nélkülözhetetlen a SEO szempontjából. Ismerje meg, hogya...

Sütik Hozzájárulás

A sütiket használjuk, hogy javítsuk a böngészési élményt és elemezzük a forgalmunkat. See our privacy policy.